O descriere clasica a unui sistem dinamic neliniar este urmatoarea:

x(t+1) = F[x(t), u(t)]

y(t) = G[x(t)]

unde ![]() , u(t)

, u(t)![]() , y(t)

, y(t) ![]() ,

, ![]() reprezinta

intrarea, iesirea si respectiv starea sistemului la momentul t, iar

reprezinta

intrarea, iesirea si respectiv starea sistemului la momentul t, iar ![]() sunt functii

neliniare necunoscute.

sunt functii

neliniare necunoscute.

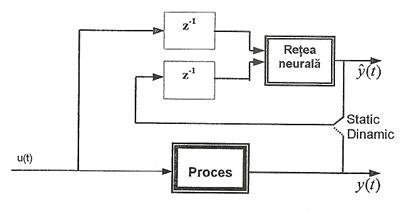

Identificarea proceselor neliniare necunoscute - care impune prelucrarea seriilor de timp dinamice - poate fi executata de catre retele neurale instruite cu date de intrare-iesire reprezentate de perechile (u, y). Configuratiile de identificare se aleg in functie de fluxul de semnale (Figura III.57). Daca la intrarea ANN se aplica iesirile masurate ale sistemului, se obtine structura statica directa (feedforward), numita model de identificare serie-paralel. Daca la intrarea ANN se aplica iesirile sistemului estimate chiar de catre retea, se obtine structura dinamica recurenta (feedback), numita model de identificare paralel.

Figura III.57. Stucturile statica si dinamica pentru ANN utilizate in identificare

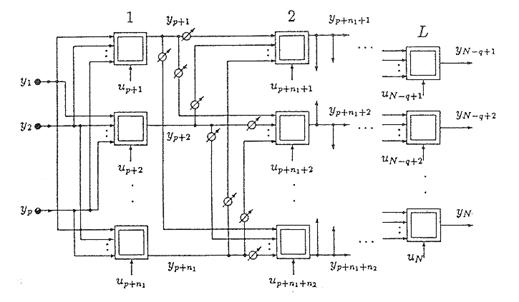

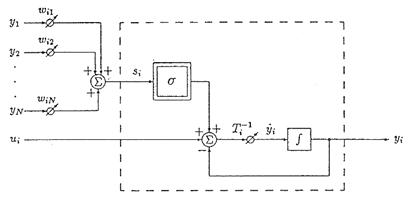

Figura III.58. Structura retelei neurale directe instruita pentru identificare prin algoritm BP

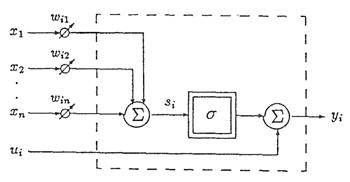

Instruirea pentru scopuri de identificare a retelelor neurale statice se face de obicei cu algoritmul BP (cu propagare inapoi), introdus de F.J. Pineda. Fie y = F(x) o relatie non -dinamica intre vectorii x si y, atunci cand parametrul t a fost eliminat. Relatia poate fi aproximata cu o retea neurala avand structura din Figura III.58 si neuronii activati printr-o functie sigmoidala (Figura III.59) :

yi = s (si) + ui , si =Swijxj

Figura III.59. Structura neuronilor elementari ai retelei din Figura III.58

Reteaua multistrat din Figura III.58 are pe nivelul de intrare p noduri de distributie, dirijate catre primul strat ascuns, ce contine n1 neuroni cu iesirile yp+1, yp+2,.,yp+n1. Acest strat este conectat la al doilea, care contine n2 neuroni si asa mai departe. Nivelul de iesire contine q neuroni. Exista conexiuni directe numai intre straturile adiacente l si l+1, l =1,L. Rezulta descrierea retelei:

Y =s (s) +u, s = Wy (6.3)

unde matricea ponderilor W are forma:

(6.4)

(6.4)

Am notat cu wi matricile ponderilor de conexiune intre doua nivele. Vectorii u si y au respectiv formele [u0,u1,...,uL ]T si [y0,y1,.,yL ]T, unde ui, yi sunt vectori corespunzatori stratului i. Daca sistemul este descris prin:

yi = fi (yi-1,.,y1), i = 1,.,N+1 (6.6)

atunci, o cale pentru calculul derivatelor partiale pentru yN+1 este relatia recursiva :

(6.7)

(6.7)

Atunci cand retelei

statice i se furnizeaza un semnal de referinta d numai pentru nivelul de iesire (![]() , pentru i = N-q,.,N),

identificarea consta in rezolvarea unei probleme de minim patratic

neliniar pentru P modele, prin minimizarea criteriului:

, pentru i = N-q,.,N),

identificarea consta in rezolvarea unei probleme de minim patratic

neliniar pentru P modele, prin minimizarea criteriului:

![]()

![]() (6.8)

(6.8)

Ajustarea ponderilor se face printr-un algoritm de gradient care - in ipoteza simplificatoare P = 1 - are forma:

![]()

![]() (6.9)

(6.9)

Ipotezele BP presupun ca pentru stratul de iesire dE/dyi = yi- dI, iar pentru straturile ascunse, derivata erorii are o propagare liniara:

(6.10)

(6.10)

unde yi se refera la nivelul l, iar yj la l+1.

Pornind de la nivelul de

iesire, relatia (6.10) poate fi rezolvata recursiv. Pe de alta parte, in ipoteza (6.7), E poate fi considerat echivalent cu Y![]() , pentru ca structura retelei este

ordonata:

, pentru ca structura retelei este

ordonata:

![]() (6.11)

(6.11)

Notand cu ![]() , obtinem astfel algoritmul BP pentru retele

statice:

, obtinem astfel algoritmul BP pentru retele

statice:

zi = ![]()

![]() (6.12)

(6.12)

![]()

Forma matriceal - vectoriala echivalenta este:

S = diag. [s'(s1)...s'(sN)]

Z = WTS.t + e

Wnou = Wvechi - a S z yT

Metoda de calcul corespunde cazului general al unei ANN integral conectate si este inerent off-line. Datorita lipsei corectiilor adaptive, atunci cand procesul real poseda neliniaritati importante si este supus unor perturbatii apreciabile, metoda este dificil de implementat si poate duce chiar la instabilitate. De aceea retelele statice pot fi utilizate limitat pentru identificarea si/sau reglarea adaptiva a sistemelor dinamice, aproximate prin ecuatii algebrice.

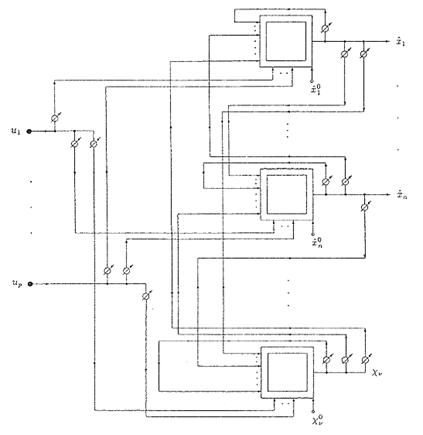

Instruirea pentru identificare a retelelor neurale dinamice este calitativ diferita de cea pentru retele statice, deoarece apare reactia negativa. O ANN dinamica integral conectata are iesirea fiecarui neuron legata pe reactie - prin ponderi variabile nenule - cu intrarile tuturor celorlalti neuroni. Schema unui astfel de neuron universal este prezentata in Figura III.60, iar arhitectura retelei unistratificate, in Figura III.61.

Figura III.60. Structura tipica a neuronului universal in retele integral conectate

Structura si comportamentul dinamic al retelelor recurente impun utilizarea a doua clase specifice de algoritmi pentru instruire, bazate pe invatarea prin punct fixat si o generalizare a acesteia, invatarea traiectoriilor.

Invatarea prin punct fixat urmareste pentru reteaua dinamica descrisa mai sus o eroare definita astfel:

![]() (6.16)

(6.16)

sunt vectorii de echilibru doriti. Cand membrul stang al ecuatie este fortat la 0, se obtine:

0 = -y![]() , k = 1, .., P

, k = 1, .., P

Figura III.61. Modelul general al unei retele neurale dinamice

In timpul instruirii,

reteaua nu primeste intrari externe, ci este excitata prin

conditiile initiale corespunzatoare spatiului de operare

ales, urmarindu-se ca iesirea ei sa evolueze spre un semnal de

referinta constant y![]() . Procedura se numeste relaxare. Pentru P = 1, relaxarea

se obtine prin algoritmul cu

propagare inapoi recurent (RBP -

recurrent BP):

. Procedura se numeste relaxare. Pentru P = 1, relaxarea

se obtine prin algoritmul cu

propagare inapoi recurent (RBP -

recurrent BP):

![]() ;

; ![]() (6.18)

(6.18)

sau, in forma matriceal - vectoriala:

![]()

(6.19)

(6.19)

Calculul lui z corespunde cazului e = -e al algoritmului BP pentru retele statice. Ecuatia pentru W trebuie rezolvata dupa ce

reteaua s-a stabilizat, adica y![]() si z

si z![]() sunt cunoscuti. Pentru anumite tipuri de

retele, cum ar fi cele Hopfield, instruirea se poate face si cu

alti algoritmi, cum ar fi cel

hebbian sau cel cu ponderi stabilite

de catre proiectant.

sunt cunoscuti. Pentru anumite tipuri de

retele, cum ar fi cele Hopfield, instruirea se poate face si cu

alti algoritmi, cum ar fi cel

hebbian sau cel cu ponderi stabilite

de catre proiectant.

Invatarea

traiectoriilor urmareste o eroare a retelei definita astfel:  (6.20)

(6.20)

unde d(t este vectorul traiectoriilor dorite, iar tl poate fi constant (in tehnicile off - line), sau variabil (pentru algoritmul on - line). Daca se ia in considerare cazul unei unice traiectorii de referinta d(t si expresia discreta in timp a erorii (6.20):

(6.21)

(6.21)

putem defini relatiile de calcul ale algoritmului de instruire cu propagare inapoi direct in timp (BPTT- Backpropagation Through Time):

(6.22)

(6.22)

Algoritmul BPTT este de fapt

o generalizare a algoritmului RBP. Reteaua recurenta

unistratificata este inlocuita cu una statica echivalenta,

avand tl nivele

(adica numarul momentelor de esantionare anterioare luate in

calcul). Noua retea se instruieste cu un algoritm BP static care

obtine valoarea finala a erorii prin insumarea valorilor intermediare

din fiecare strat. Ponderile straturilor intermediare caracterizeaza erori

partiale, "vazute" la diferite momente de timp. In final va fi invatata

traiectoria constanta ![]() .

.

![]()

Forma echivalenta matriceal-vectoriala a relatiilor (6.22) este:

(6.23)

(6.23)

Pentru ca in timpul instruirii algoritmul BPTT utilizeaza retelele cu propagare directa ca un echivalent al reactiilor din reteaua dinamica, el este esential nerecurent. Teoretic, algoritmul poate fi utilizat on-line, dar volumul de calcul si necesarul de memorie sunt considerabile.

O buna posibilitate de instruire on-line a retelelor neurale dinamice este oferita de algoritmul cu propagare inainte (FP - forwardpropagation). Daca in ecuatia modelului neuronului (6.14) suprimam, pentru claritate, Tk, obtinem:

(6.24)

(6.24)

unde dik este simbolul lui Kronecker. Pentru t![]() si presupunand ca neuronii sunt integral

conectati, eroarea se poate defini astfel:

si presupunand ca neuronii sunt integral

conectati, eroarea se poate defini astfel:

dt (6.25)

Prima variatie a acestei erori este:

(6.26)

(6.26)

Se poate demonstra matematic existenta unei metode de calcul on-line a ponderilor pentru minimizarea acestei erori, cu observatia ca la implementarea se utilizeaza o matrice tridimensionala.

|

Politica de confidentialitate |

| Copyright ©

2025 - Toate drepturile rezervate. Toate documentele au caracter informativ cu scop educational. |

Personaje din literatura |

| Baltagul – caracterizarea personajelor |

| Caracterizare Alexandru Lapusneanul |

| Caracterizarea lui Gavilescu |

| Caracterizarea personajelor negative din basmul |

Tehnica si mecanica |

| Cuplaje - definitii. notatii. exemple. repere istorice. |

| Actionare macara |

| Reprezentarea si cotarea filetelor |

Geografie |

| Turismul pe terra |

| Vulcanii Și mediul |

| Padurile pe terra si industrializarea lemnului |

| Termeni si conditii |

| Contact |

| Creeaza si tu |